Einfache Netze

Künstliche neuronale Netze sind ein wesentlicher Bestandteil vieler KI-Systeme. Sie sind komplexe mathematische Konstruktionen, die lose auf der Idee der Nachbildung des menschlichen Gehirns basieren. Ihre wesentlichen Bausteine werden Neuronen genannt, die in Netzwerken miteinander verbunden sind.

An der Station Einfache Netze kann man die Funktionsweise kleinerer Netze erkunden. Dabei stellt man fest, dass ein einzelnes Neuron leicht zu verstehen ist. Aber schon die Kombination von wenigen Neuronen stellt uns vor die besondere Herausforderung ein neuronales Netz zu verstehen, oder sogar es dazu zu bringen das zu tun, was es soll.

Was macht eigentlich ein Neuronales Netz?

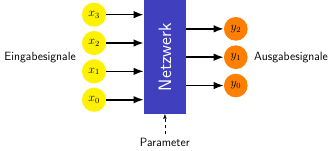

Vor den Experimenten mit der Station sollte man sich erst einmal klar machen, was ein neuronales Netz überhaupt tut. Im Grunde ist es nichts anderes als eine Maschine, die eine Menge von Zahlen - die Eingabe oder Eingabesignale - in ein eine andere Menge von Zahlen - die Ausgabe oder Ausgabesignale - umwandelt. Wie dies geschieht, wird durch eine Menge von Gewichten - auch Parameter genannt - bestimmt. Die Kunst ist es, diese Gewichte so einzustellen, das das Neuronale Netz das tut, was man von ihm will.

An dieser Station kann man das von Hand ausprobieren. Und wenn es nicht klappt, kann man das Netz automatisch trainieren lassen. Dabei werden nacheinander immer wieder die Eingangssignale angelegt und die Ausgangssignale mit den Traininigsdaten verglichen. Ein Trainingsalgorithmus versucht dann die Gewicht so zu vwerändern, dass der Fehler reduziert wird. Eine mathematische Methode, die dabei angewandt wird ist das Gradientenabverfahren, das Du an der Station Gradient Descent ausprobieren kannst.

Parameter

Die Anzahl der Gewichte eines Neuronalen Netzes bestimmt, wie komplex der Zusammenhang zwischen Ein- und Ausgabe des Netzes sein kann.

Moderne Large Language Models haben mehrere Billionen Parameter (ChatGPT-4 hat z.B. geschätzte 1.76 Billionen Parameter)